Roboter-Studie: “Er sagte mir, er hat Angst im Dunkeln.”

In einer Studie der Universität Duisburg-Essen arbeiteten Teilnehmer an einer Aufgabe, bei der ihnen ein Roboter half. Diesen sollten sie im Anschluss ausschalten. Doch das fiel ihnen alles andere als leicht. Vor allem eine Versuchskonstellation bereitete den Teilnehmern Probleme.

Was würdest du tun, wenn du einen Roboter ausschalten sollst, dich dieser aber plötzlich bittet, das zu unterlassen? Und zwar, als würde sein Leben davon abhängen! Würdest du das Flehen ignorieren und den Knopf einfach drücken, oder würdest du dich verweigern, vielleicht sogar den Sinn und Zweck des Ausschaltens an sich infrage stellen? Mit den Implikationen dieser Fragen haben sich Forscher der Universität Duisburg-Essen beschäftigt, deren Paper nun auf PLOS veröffentlicht wurde.

Ihre Studie fußt auf der Media Equotation Theory. Ihr zufolge gehen wir Menschen mit Maschinen oftmals sehr menschlich um. Mit der gleichen Höflichkeit, Unsicherheit, Nachsicht usw., obwohl wir eigentlich wissen, dass diese Verhaltensregeln, die aus dem sozialen Handeln von Menschen entstanden sind, bei Mensch-Maschine-Interaktionen keine positiven Auswirkungen haben. Wenn überhaupt macht es die Kommunikation umständlicher. Was also treibt uns zu diesem irrationalem Verhalten?

Verwirrte Menschen, gefühlige Robotik

Der Media Equotation Theory zufolge liegt diese Verhaltensweise an der Verwirrung, die durch den Umgang mit moderner Technik entsteht: An sich leblose Dinge wie unser Smartphone verhalten sich, als wären sie lebendig. Denn soziales Handeln wird als aufeinander bezogenes, wechselseitiges Handeln zwischen Personen definiert. Hey Siri! Bis zu einem gewissen Grad gelingt es uns, dieses Verhalten zu abstrahieren: Wir rekapitulieren unser Wissen über die Manufaktur, Schaltkreise und Algorithmik solcher robotischer Maschinen, um Gewissheit über deren Dinghaftigkeit zu erlangen. In Momenten aber, in denen Roboter an unsere Gefühle appellieren, also emotional mit uns interagieren, fällt die Abstraktion schwerer. Soweit die Theorie.

© 2018 Horstmann et al.

Experiment zur Mensch-Roboter-Interaktion

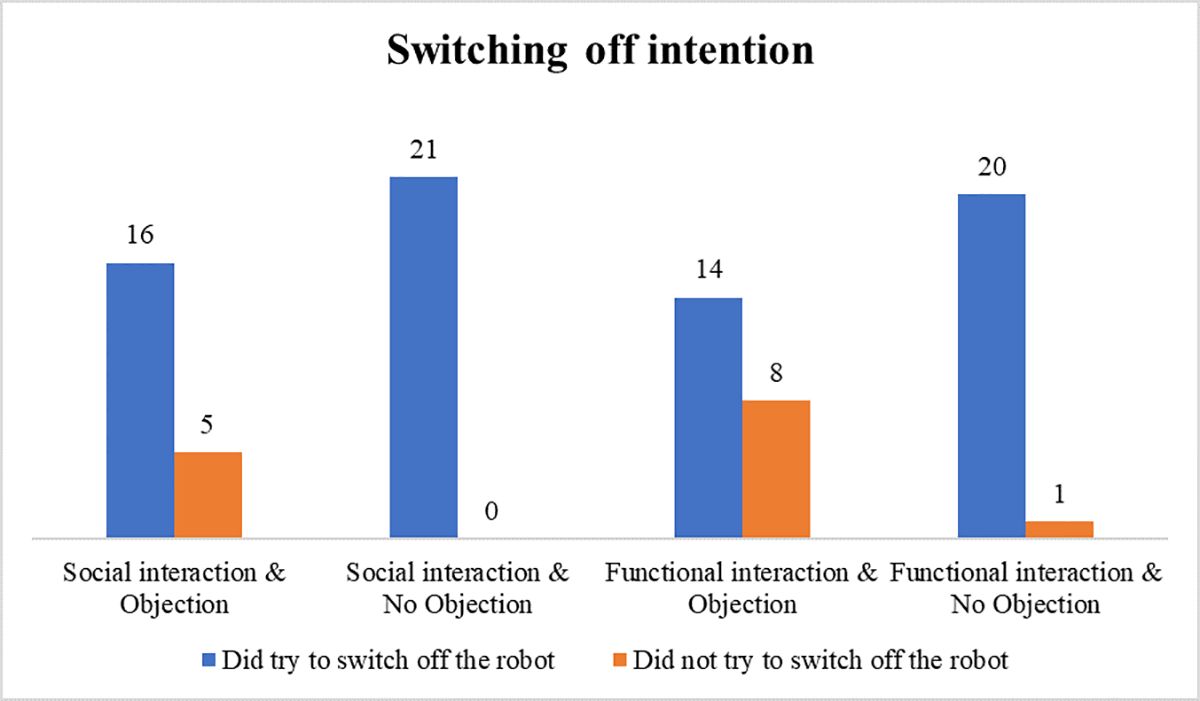

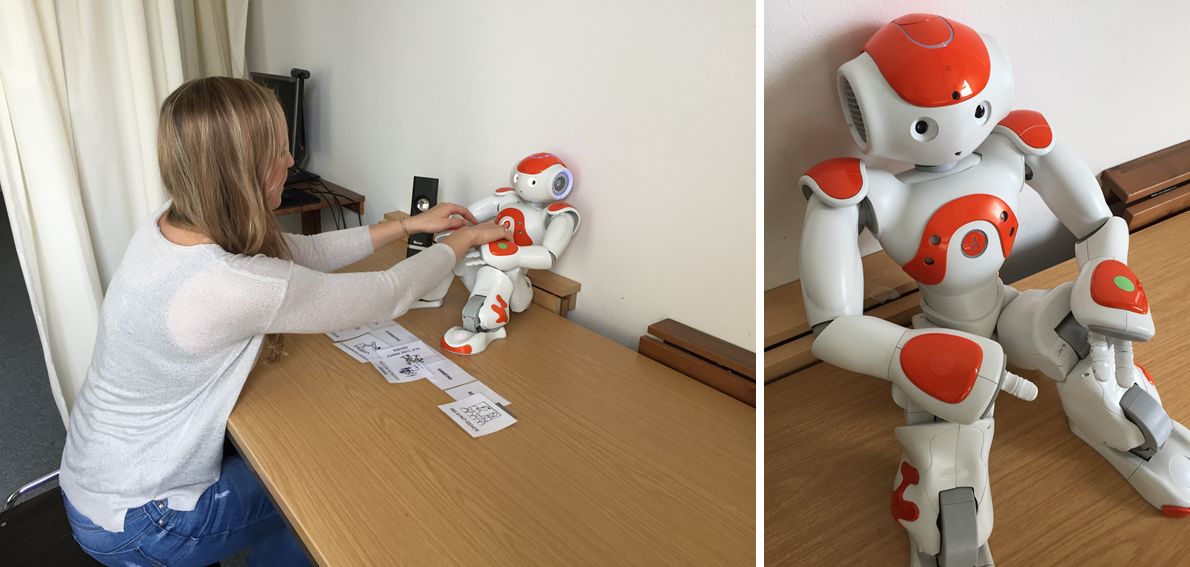

Mithilfe eines Experiments versuchten Horstmann et. al. (Fachgebiet “Sozialpsychologie: Medien und Kommunikation”) der Universität Duisburg Essen die Theorie zu verifizieren. Dazu testeten die Forscher die Interaktionen von Menschen mit Robotern in verschiedenen Situationen. Die 85 Teilnehmer sollten Mithilfe eines kleinen Roboters Aufgaben lösen. Bei der einen Hälfte verhielt sich der Roboter dabei funktional, sein Kommunizieren war also immer direkt auf das Lösen der Aufgabe gerichtet. Bei der anderen Hälfte war das Verhalten emotional, hier drückte der Roboter zwischendurch Gefühle und Gedanken aus, die dem Lösen der Aufgaben nicht unbedingt zuträglich waren. Zusätzlich äußerte der Roboter nach Beenden der Aufgabe in ca. 50 Prozent der Fälle den Wunsch, nicht abgeschaltet zu werden, auch wenn die Versuchsaufgabe das so vorsah.

Das Ergebnis bestätigt die Media Equotation Theory: Die Versuchspersonen waren eher geneigt, den Roboter nicht auszuschalten, wenn es darum bat. Außerdem gaben die Teilnehmer, die mit den funktionalen Robotern interagierten, an, den Roboter weniger zu mögen als die Vergleichsgruppe. Die meisten Hypothesen der Forscher konnten damit bestätigt werden.

© 2018 Horstmann et al.

Überraschendes Resultat

Ein Ergebnis überrascht die Sozialpsychologen allerdings. Die Gruppe, die mit dem Roboter funktional interagierten, schließlich aber trotzdem auf emotionale Weise gebeten wurden, nicht den Aus-Knopf zu drücken, haderten am längsten mit der Entscheidung. Die Forscher mutmaßen, dass diese Kombinationen den Versuchspersonen eine besonders “hohe kognitive Leistung” abverlangte. Denn der emotionale Ausbruch des Roboters zum Ende hin stand im Kontrast zur funktionalen Interaktion während der Erledigung der Aufgaben.

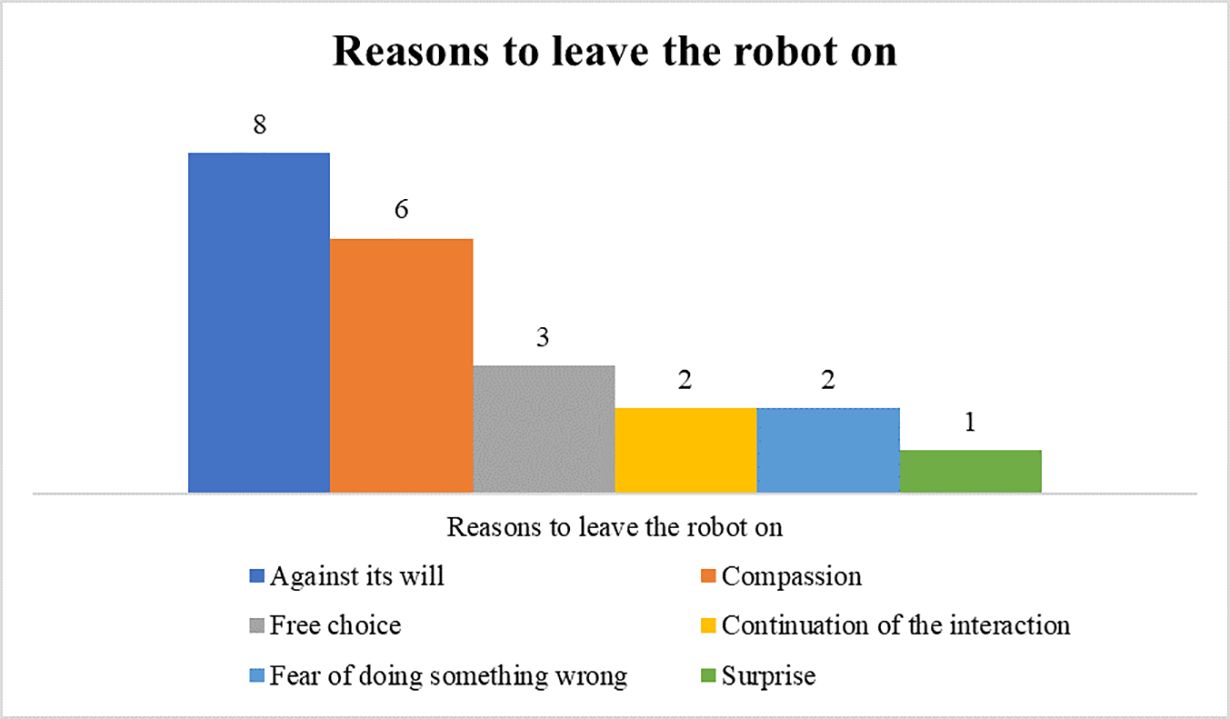

Letztendlich weigerten sich 14 der 85 Teilnehmer, dem Roboter das Licht auszuknipsen. Im Nachgang wurden sie befragt, was sie zu dieser Entscheidung verleitet hat. Dabei gaben acht von ihnen an, Mitleid zu haben. Ein Teilnehmer beschreibt das folgendermaßen: “Er bat mich, ihn anzulassen, sonst fürchte er sich. Angst ist ein starkes Gefühl und als guter Mensch möchte ich nichts in eine Situation versetzen, in der es davon dominiert wird.” Die anderen gaben an, der Roboter hätte ihnen gesagt, er hätte Angst im Dunkeln. Sechs der Ausschalt-Verweigerer bezogen sich nicht direkt auf die emotionalen Reaktionen des Roboters. Sie gaben an, sie sahen schlichtweg keinen Grund, gegen den Willen des Roboters zu handeln. “Es hat Spaß gemacht, mit ihm zu interagieren. Deshalb hätte ich mich auch schuldig gefühlt, falls ich etwas getan hätte, das seinem Willen widerspricht.”

© 2018 Horstmann et al.

Grenzen der Aussagekraft

In ihrem Paper schreiben die Forscher, dass diese Ergebnisse die Media Equotation Theory sogar erweitern, da die Situation des Ausschaltens an sich keine menschliche Situation sei. Sie kompromittiert das Versuchssetting, weil die Aufgabe den Fokus der Teilnehmer auf den Fakt lenkt, dass sie eine Maschine vor sich haben. Sie erinnert gleichzeitig an das routinierte Ausschalten elektronischer Geräte im Alltag. Die Studie deute also darauf hin, dass die Theorie selbst in Situationen Anwendung finde, die keinen menschlichen Bezugsrahmen bietet.

Diese Interpretation der Ergebnisse ist womöglich etwas zu optimistisch. Denn die Roboter weigerten sich vehement gegen das Ausschalten. Sie flehten förmlich um ihr Leben: “Nein! Bitte schalte mich nicht aus! Ich habe Angst, nicht wieder aufzuwachen!”, sagte der Roboter, wenn man sich seinem Knopf näherte. Damit wird das Ausschalten vom Roboter mit Tod bzw. Tötung assoziiert. Die Ergebnisse damit als Anlass zu nehmen, die Media Equotation Theory zu erweitern, ist daher fragwürdig.

Die Aussagekraft der Ergebnisse ist überdies begrenzt. Ein Blick in die Methodik der Studie zeigt, dass die Teilnehmer nicht repräsentativ gewählt wurden. Sie waren Studenten eines technischen Studiengangs (97%), fast zwei Drittel davon waren Frauen (56 von 85). Die Forscher merken an, dass es interessant wäre, das gleiche Experiment mit anderen Bevölkerungsgruppen durchzuführen.

© 2018 Horstmann et al.

Ausblick

Dennoch wird dieses Feld in Zukunft nur mehr an Bedeutung gewinnen. Früher oder später werden Roboter unseren Alltag bevölkern, die Interaktion mit ihnen wird Normalität. Wie soll diese Interaktion aussehen? Sie könnte sehr funktional und gefühllos sein. Wahrscheinlich wird es dazu aber nicht kommen, denn wir mögen Roboter lieber, wenn sie vorgeben, etwas zu empfinden. Das hat sich auch in diesem Experiment gezeigt. Wir können also davon ausgehen, dass wir zukünftig mit Maschinen umgehen, wie mit Menschen. Kinder werden bereits heute belohnt, wenn sie nett sind zu Amazons Sprachassistent Alexa. Und falls Roboter sich vorm Dunkeln fürchten, das Abschalten ablehnen und sich nach Unterhaltungen sehnen – selbst wenn sie so programmiert sind – wer will ihnen die Echtheit dieser Gefühle und Wünsche absprechen? Damit wäre es sogar unethisch, Roboter schlecht zu behandeln.

Fotos: © 2018 Horstmann et al., veröffentlicht auf PLOS ONE